Šį rašinį KTU informatikos doktorantas Lukas Stankevičius parašė 2019 m. mokslo populiarinimo rašinių konkursui. Primename, kad panašių rašinių, publikuoti šiame puslapyje laukiame nuolatos. Juos siųskite: [email protected]

Lukas Stankevičius

Su šeima žiūrėjome animacinį filmą „Wall-E“, kur žmonės ateityje vaizduojami nepaeinantys tinginiai – robotai juos lovose vežioja, aprengia, maitina, paduoda telefonus. Vienintelė likusi funkcija – bendravimas su kitais per išmaniuosius įrenginius. Tačiau aš drįsčiau paprieštarauti. Žvelgdamas vien į šių metų dirbtinio intelekto pasiekimus kalbos srityje, galiu teigti, kad mums nereikės ir kalbėti. Norėdami rasti vakarienei su mylimuoju/mylimąja vietą, duosime maždaug tokią komandą kalbos sistemai “mano sistema xxx, užsakyk staliuką dviems, kokiam geram restorane, kur nors netoli”. Arba, sudėtingesniais atvejais: “aš noriu išsiskirti su jau nemylima/nemylimu, pašnekėk su ja/juo …” Atrodo baisiai? Juk kalbos sistema yra ir kitoje pusėje. Na, o ką ateityje tuomet galėtume veikti mes, arba, kas bus likę mums beveikti, palikime šį klausimą filosofams.

Ne veltui minėjau staliuko užsakymą – tai jau įmanoma. Dar 2018 m. gegužę Google pristatė savo asistentą Google Duplex [1], kuris, kaip teigiama, ir yra skirtas tokiems užsakymams. Per pristatymą buvo parodyta, kad asistentas netgi daug geriau susigaudė apie ką kalbama, nei restorano telefonu atsiliepusi moteris, ir daug kam auditorijoje tai sukėlė juoką. Mums juokinga, nes asistentui tai buvo sunki situacija dėl žmogaus nesupratingumo. Bet jis ją įveikė.

Google Duplex nėra vienintelis. Kitas gerai žinomas yra Amazon Alexa. Tai garso kolonėlės pavidalo įrenginys, valdomas balsu. Alex’os paprašius, ši gali paleisti norimą muziką, nustatyti žadintuvą, paaiškinti terminą, pasakyti orų prognozę, pranešti naujausias žinias ir t. t. Beveik kiekviena didžioji kompanija yra sukūrusi kokį nors asistentą. Samsumg – Bixby, Apple – Siri; Microsoft – Cortana.

Kiekvienas norėtume asistento, kuris už mus, o ne prieš mus pakalbėtų. Deja, pasaulyje jau vyksta “prieš”. Garsi JAV laida „Last week tonight“ 2019 m. kovą net išleido laidą [2] skirtą robotų skambučiams. Tai nėra paprasto balso įrašai, kaip esame įpratę girdėti paskambinę paslaugų numeriu ir tada paspaudę pvz. trejetą. Minėtoje laidoje aptariamuose skambučiuose robotai reaguoja labai įtikinamu balsu į tai, ką mes pasakome. Atskirti, kad skambina robotas (kompiuteris) galima, tačiau tai užtrunka (reikia pasukti galvą, ko paklausti). Tenka arba aukoti savo laiką, arba neatsakinėti nežinomiems numeriams.

Mokslo pasaulyje garsiai nuskambėjo GPT-2 modelio nepublikavimo atvejis. OpenAI organizacija, sukūrusi šį kalbos modelį, nusprendė jo neišleisti (nors pačios organizacijos pavadinimas sako ką kita). Priežastis – GPT-2 modelis pasirodė „per geras“. Teigta, kad žmonės jo sugeneruotą tekstą neatskirs nuo tikrų žmonių parašyto. Baimintasi, kad su šiuo modeliu melagingų naujienų sukūrimas gali tapti labai greitu vieno žmogaus darbu. Nepaisant šių baimių, pasirodė dar „baisesnių“ kitų modelių ir GPT-2 dabar yra jau laisvai prieinamas.

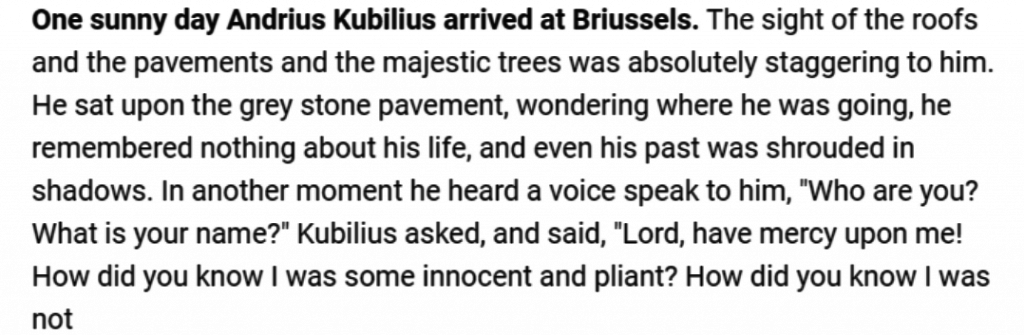

Dabar plačiau apie būtent šį modelį. GPT-2 modelis [3] yra tikrai ne žaisliukas. Remiasi vos 2017 m. sukurta Transformerio architektūra [4]. Turi net 1,5 mlrd. parametrų. Modelis apmokytas su 8 milijonais kokybiškų žiniatinklio puslapių. Pats apmokymas truko virš 2000 TPU (angl. Tensor Processing Unit, vaizdo plokštės GPU “giminaitis”) dienų [5]. Apmokyti tokio lygio modelį iš viso gali kainuoti virš 60000 dolerių [6] (o kur dar išlaidos testavimams ir t. t.). Šį modelį galima išbandyti internete [7] (keli pavyzdžiai pateikti žemiau paveikslėliuose). Tereikia suvesti savo pradinį tekstą (anglų kalba) ir nurodyti, kad toliau tekstą generuotų GPT-2. Patys įvertinkite, kaip tekstą generuoja modeliai. Pamatysite, kad nors ir dažnai sugeneruoja rišlų sakinį, kartais iš didelio rašto išeina iš krašto. Siūlau perskaityti ir vieną geriausių generavimo atvejų apie vienaragius, pateiktą adresu [3].

Paveikslėliuose paduotas tekstas paryškintas, o modelio sugeneruotas yra neparyškintas [7].

Ten, kur šie modeliai dabar tikrai gerai veikia – tam tikros užduotys, kurioms jie yra specialiai apmokyti. Kaip pavyzdys – teksto suvokimo užduočių tekstynas RACE [8], sukurtas aukštosios mokyklos studentams. Čia pateikiami tokie klausimai, kaip „koks geriausias šios ištraukos apibūdinimas?“, „koks buvo autoriaus požiūris į …“, „kurie teiginiai yra neteisingi?“, „jei ištrauka atsidurtų laikraštyje, kuri pastraipa būtų tinkamiausia?“, „pirmas pašto ženklas buvo pagamintas ___“. Šio tekstyno klausimai buvo specialiai sukurti paruošti kinų studentus stojimo į aukštąsias mokyklas egzaminams. Ar jums būtų tokie klausimai sunkūs? Geriausi kalbos algoritmai atsako 89,4 % klausimų teisingai. Tai yra bene vienintelis tekstynas, kur žmonės dar pirmauja. Kitose užduotyse [9] kompiuteriniai algoritmai paprastus žmones jau seniai aplenkia.

Kyla klausimas, kodėl modeliams dar nepavyksta pilnai įtikinti žmonių savo pasakomis, bet štai tam tikrose užduotyse žmonės absoliučiai aplenkiami? Uždaras sistemas su griežtomis taisyklėmis besimokantys algoritmai gali perprasti, tačiau atviros sistemos (pvz. pokalbis su gyvu žmogumi), kaip teigė legendinis šachmatininkas Garry Kasparov [10], yra per daug plačios. Dėl to dabartiniams algoritmams dar sunku sugeneruoti melagingas naujienas ar įtikinti žmones. Žmonės yra tiesiog per daug universalūs.

Vis dėlto, niekas nežino, kaip gali pasisukti kalbos modelių tyrimai. Greitis, kuriuo vystosi ši sritis, yra tiesiog įspūdingas. Žemiau pateikiu kada ir kokie kalbos modeliai atsirado, pralenkę iki tol buvusius. Štai kokios lenktynės vyksta:

2018 spalio 11: BERT [11];

2019 vasario 14: GPT-2 [3];

2019 birželio 19: XLNET [12];

2019 liepos 26: RoBERTa [13];

2019 rugsėjo 26: ALBERT [14];

2019 spalio 23: T5 [15].

Turbūt jau supratote, kad kol kas dirbtinis intelektas mokosi tik anglų kalbos. Iš įdomesnių lietuvių projektų galima paminėti nebent “dirbtinį idiotą” anoniminį komentatorių „Artūrka“, kurio svetainė po dviejų metų jau nebeveikia. Mašininio mokymosi mokslo padėtis Lietuvoje yra prilygintina “pralaimėtam pirmajam kėliniui”. Tačiau nenusiminkime, nes iš tiesų tik laiko klausimas, kada turėsime lietuvišku žodžiu valdomą asistentą, generuosime lietuvišką tekstą ir vargins lietuviškų robotų skambučiai. Jei tik pakankamai įsisavinsime anglų kalboje esančias technologijas, gal net jau ir kitas šio teksto autoriaus darbas būtų … na taip tariant … ne visai šio autoriaus.

Šaltiniai:

[1] Google Duplex pristatymas. Prieiga per internetą: https://youtu.be/D5VN56jQMWM

[2] Robocalls: Last Week Tonight with John Oliver (HBO). Prieiga internetu: https://youtu.be/FO0iG_P0P6M

[3] RADFORD, Miles, et al. Better Language Models and Their Implications. Prieiga per internetą: https://openai.com/blog/better-language-models/

[4] VASWANI, Ashish, et al. Attention is all you need. In: Advances in neural information processing systems. 2017. p. 5998-6008.

[5] MANNING, Chris. Modeling contexts of use: Contextual Representations and Pretraining. Prieiga per internetą: http://web.stanford.edu/class/cs224n/slides/cs224n-2019-lecture13-contextual-representations.pdf

[6] The Staggering Cost of Training SOTA AI Models. Prieiga per internetą: https://syncedreview.com/2019/06/27/the-staggering-cost-of-training-sota-ai-models/

[7] GPT-2 modelio vartotojo sąsaja. Žiūrėta 2019-11-24. Prieiga per internetą: https://talktotransformer.com/

[8] RACE skaitymo suvokimo užduočių tekstynas. Prieiga per internetą: http://www.qizhexie.com/data/RACE_leaderboard.html

[9] GLUE kalbos modelių užduotys. Prieiga per internetą: https://gluebenchmark.com/tasks

[10] Artificial Intelligence (AI) Podcast. Garry Kasparov: Chess, Deep Blue, AI, and Putin. Prieiga per internetą: https://youtu.be/8RVa0THWUWw

[11] DEVLIN, Jacob, et al. Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805, 2018.

[12] YANG, Zhilin, et al. XLNet: Generalized Autoregressive Pretraining for Language Understanding. arXiv preprint arXiv:1906.08237, 2019.

[13] LIU, Yinhan, et al. Roberta: A robustly optimized bert pretraining approach. arXiv preprint arXiv:1907.11692, 2019.

[14] LAN, Zhenzhong, et al. Albert: A lite bert for self-supervised learning of language representations. arXiv preprint arXiv:1909.11942, 2019.

[15] RAFFEL, Colin, et al. Exploring the limits of transfer learning with a unified text-to-text transformer. arXiv preprint arXiv:1910.10683, 2019.